ChatGPT:

ごめんなさい。いままで探した範囲では、Massachusetts Institute of Technology(MIT)が「AIの歴史を塗り替えるテンソル台数」について“テンソル(Tensor)チップやラックを○万台投入しました”といった大規模発表をした論文・公式ニュースとして、信頼できる一次資料を確認できていません。

ただし、関連して興味深いMITの研究や業界動向はいくつかあり、雑学・業界話も交えて解説できます。よければ、それらをご紹介します。以下に3つピックアップします。

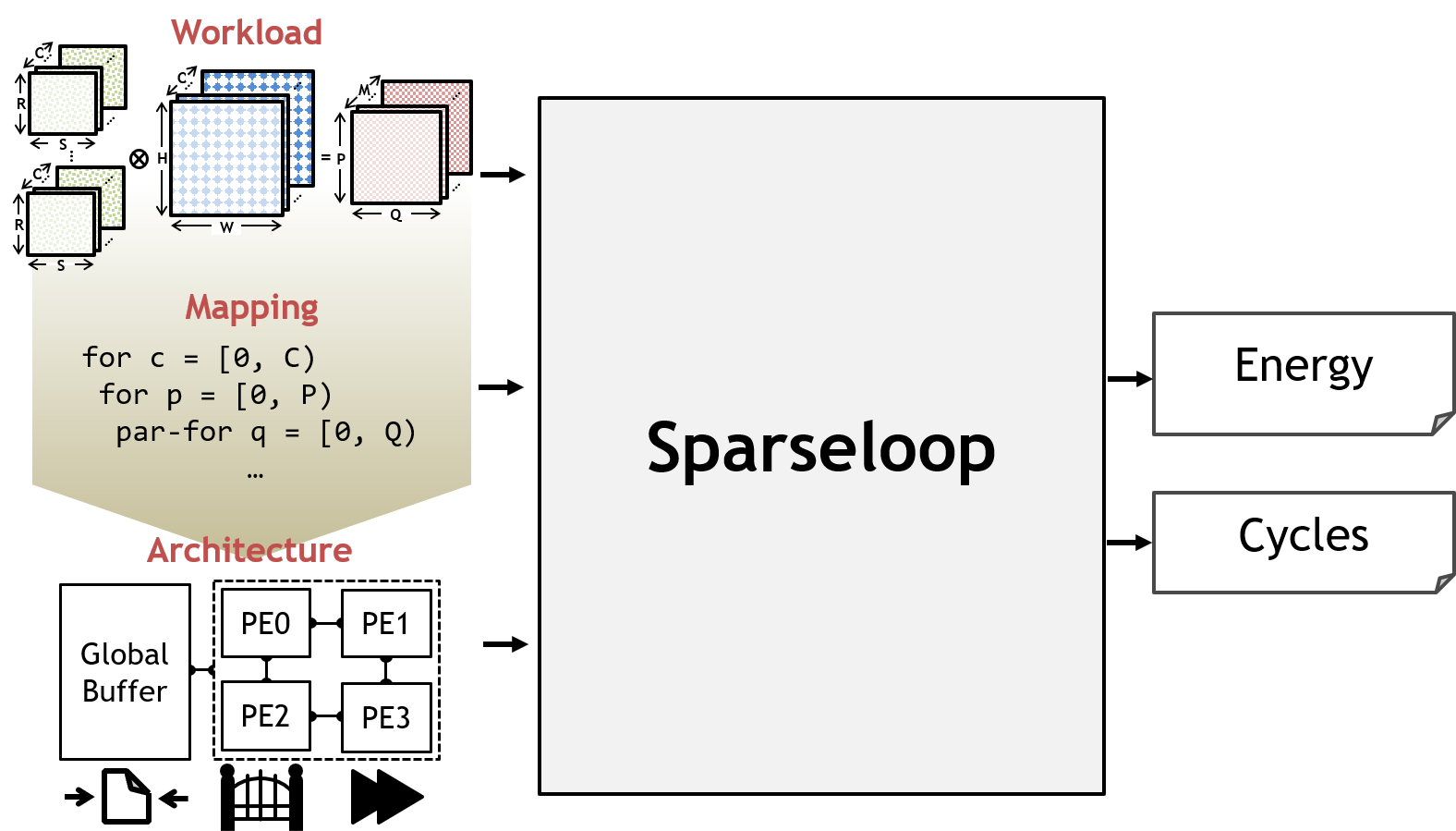

1.スパース・テンソル処理を加速するMIT+NVIDIAの研究

-

MITとNVIDIA Corporationの研究チームが、「スパース(0が多い)テンソル」の処理を効率化する2つの手法(HighLight と Tailors/Swiftiles)を発表しました。 MIT Schwarzman College of Computing

-

背景として、AIモデル(特に大規模な言語モデルなど)はテンサ―(多次元配列)演算が中心ですが、その中には「値がゼロ」の部分(スパース部分)が相当量あります。ゼロをそのまま計算・メモリ移動すると無駄なので、スパース構造を活かせば性能・省電力面で大きな改善が得られます。 MIT Schwarzman College of Computing

-

研究のポイント:

-

どこに非ゼロ値があるかを効率的に探すハードウェア技術を提案。

-

各領域(サブテンソル)ごとに非ゼロ数が偏るため、バッファの割り当てを固定にしづらいという課題に対処。

-

汎用性をある程度保ちつつ、専用加速器的なアプローチを模索。

-

-

業界雑学として:

-

「スパース化」はモデル軽量化(pruning/量子化)と並んで、AI推論・訓練効率を上げる潮流です。

-

たとえば、GPU/TPUなどのアクセラレータでは、スパースを活かせるかどうかで“性能差”が出始めており、次世代ハードウェア設計の鍵になっています。

-

MITのこの研究は、単に「もっとチップを増やす」ではなく「既存リソースを賢く使う」方向の先端です。

-

2.フォトニック(光)プロセッサ:光によるAI演算

-

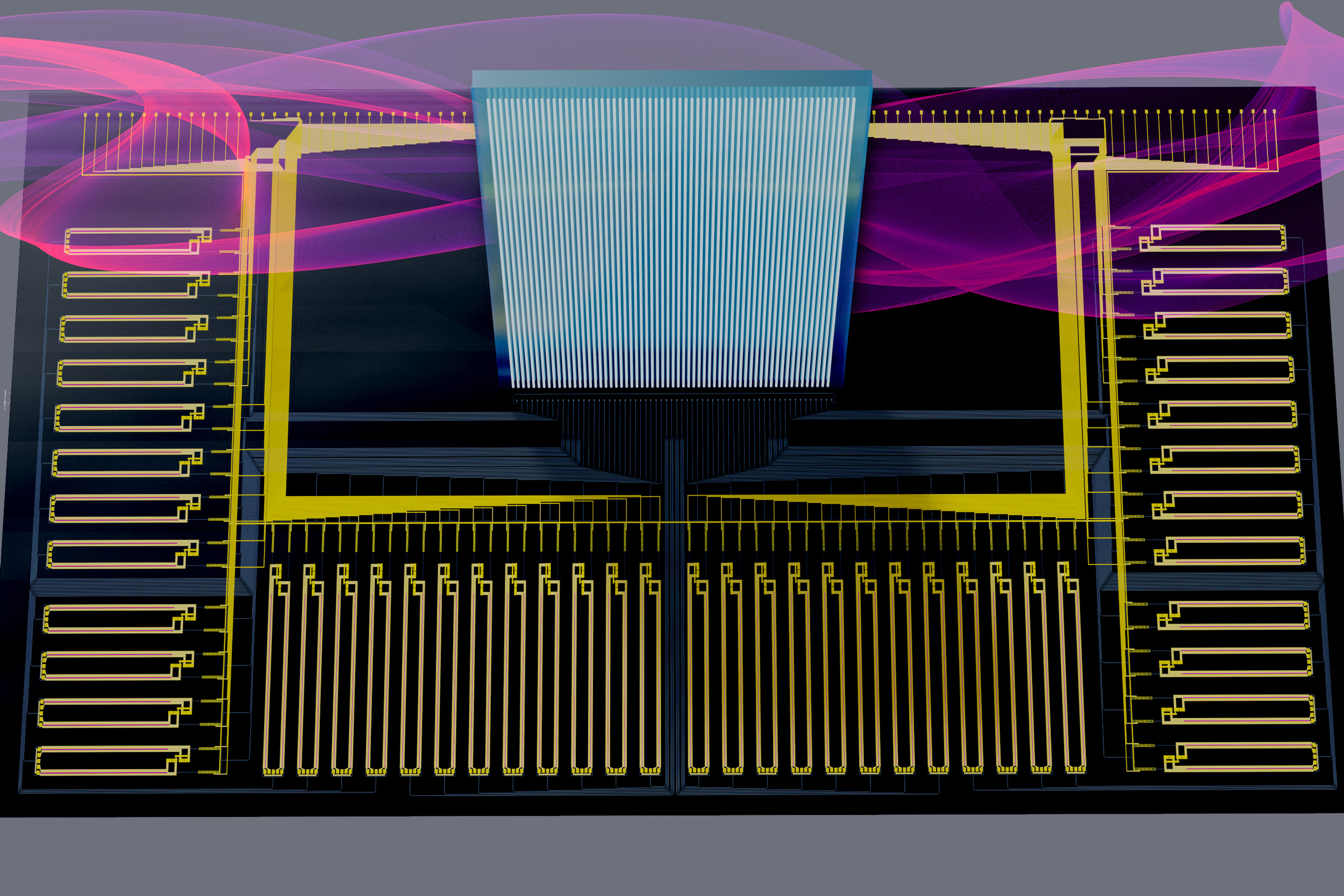

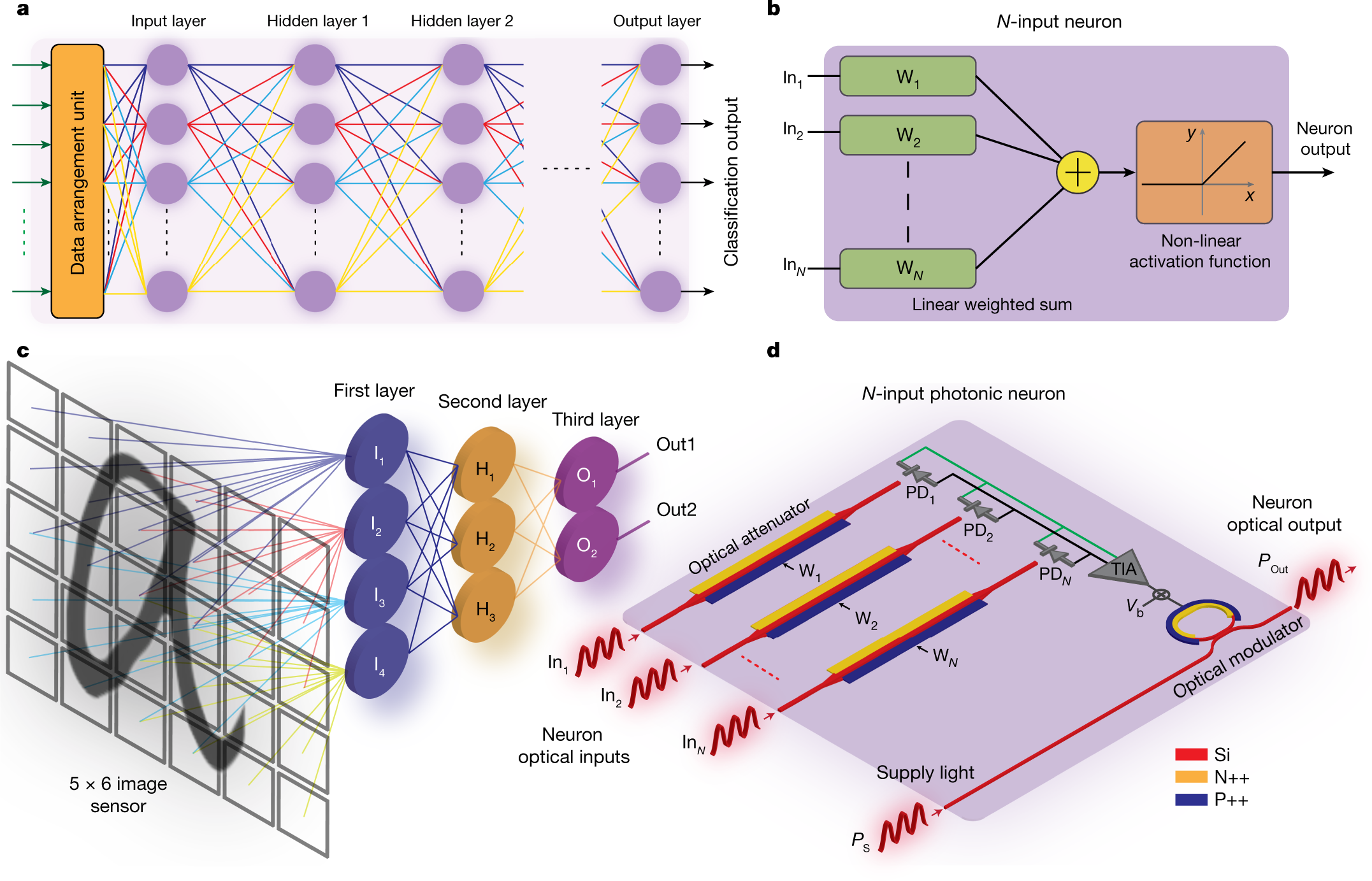

2024年12月、MITが「深層ニューラルネットワークの主要な演算を光で行えるチップ」を発表しました。 MITニュース

-

ポイント詳細:

-

通常、行列乗算・線形変換は電子回路(トランジスタ)で、非線形活性化などを電子/アナログ変換して処理します。

-

この研究では、光学ビームスプリッタや非線形光関数ユニット(NOFUs)を使って「線形+非線形演算をチップ内で光ドメインで完結」するプロセッサを実証しています。 MITニュース

-

結果として、ナノ秒単位の処理時間・電子回路に比べて極めて低レイテンシ・低消費電力の可能性を示しています。

-

-

業界的な意味合いと歴史的雑学:

-

AI推論・訓練では「演算数」だけでなく「演算までの時間」「通信・メモリ移動コスト」「消費電力/熱」が制約になっています。光信号を使えば「電荷移動」「配線遅延」「電力損失」といった電子特有のボトルネックを一部回避できます。

-

過去、1980〜90年代のスーパーコンピュータ思想(例えば通信・配線を大量に並列にする)を思い起こさせるところもありますが、AI専用回路設計と光回路/アナログ技術の融合という点で“次の波”と言えます。

-

「テンソル台数をただ増やす」アプローチだけでなく、実質的な効率を高める「構造改革」がハードウェア側で本格化しています。

-

3.業界スケール:ラックあたり「メガワット級/テンソル数千~万台級」インフラ設計の潮流

-

AIモデル(特に生成AI/巨大言語モデル)を訓練・推論するインフラでは、「チップ数・GPU/TPU/アクセラレータ数」の“数”が注目されています。そしてそれを物理的に収めるラック・データセンター設計が重要になっています。

-

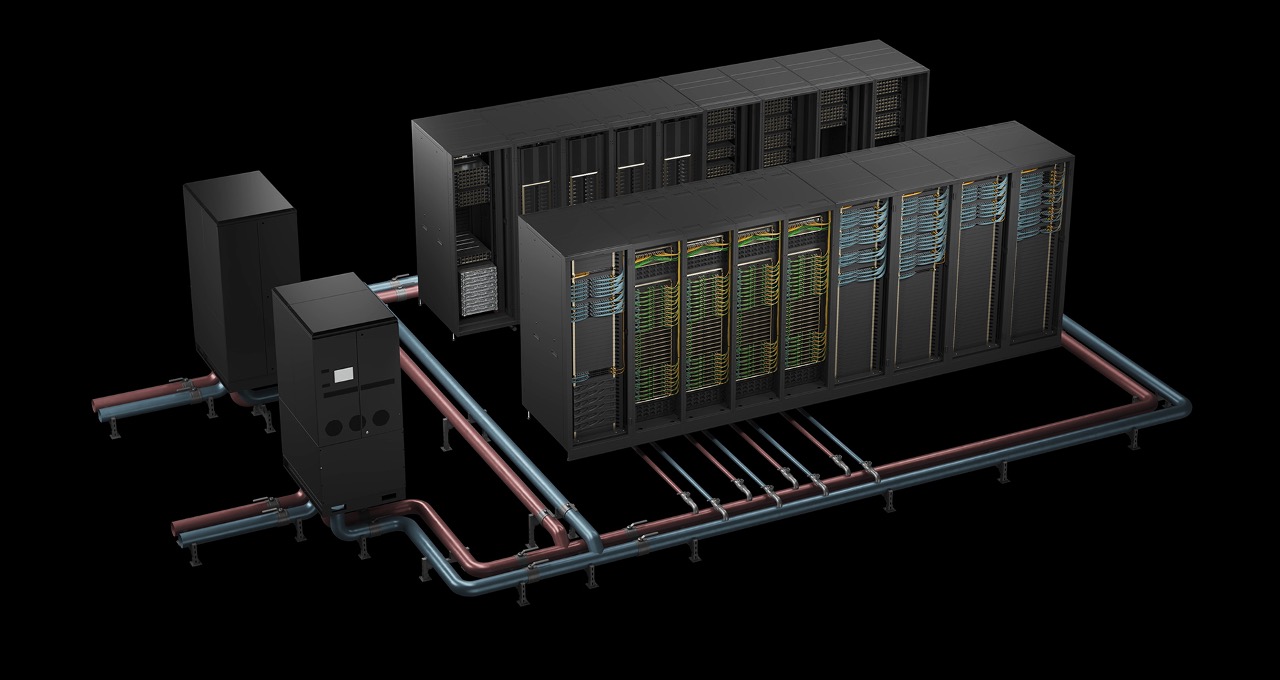

例えば、「1ラック=1メガワット級」「ラック内にAIアクセラレータ数千/数万」といった規模設計が「近未来的な常識になりつつある」という記事があります。 Medium

-

こうした設計に絡む雑学・裏話:

-

ラックあたりの消費電力が1 MWを超えると、電源供給・冷却・床強化・配線密度・電磁干渉(EMI)など、IT機器設計を超えた“工学”の世界になります。

-

多くのAIハードウェア設計者・データセンタ担当者は「どれだけチップを増やすか」ではなく「どうチップを冷やすか」「どう通信をボトルネックにせず拡張するか」「どう利用率を高めるか」に頭を悩ませています。

-

つまり、「テンソル(演算ユニット)を何万台並べる」という数的拡張だけでなく、それを支える周辺設計(電源・冷却・通信・故障対応など)が“勝負”となってきています。

-

-

この視点で、もしMITが「テンソル台数を過去最大規模で投入しました」という発表をしていたと仮定すると、実はその裏に「データセンターの規模設計」「冷却・通信・電源インフラ」の話がセットになっている可能性が高い、ということになります。

なぜ「テンソル台数」がニュースになるか—業界話

-

AIモデル(LLMなど)のパラメータ数・演算数(FLOPs)・学習時間が急速に増大しており、演算プラットフォーム側もスケーラビリティが要求されている。

-

そのため、単純に「もっと高速なチップ」ではなく、「大量に並列に動かす」「通信・メモリ・電力効率を同時に改善する」ことが鍵。

-

「テンソル台数を◯万台にしました」という発表は、単なる演算能力だけでなく「大規模運用のインフラ能力」が整備されたことを示す“マイルストーン”になり得る。

-

また、ビジネス/研究競争において「ハードウェアの規模」が一種のステータスになる側面もある(例:どこまで“多くのアクセラレータを使えるか”が広告材料になりえる)。

-

ただし、規模を大きくすればいい、というわけではなく、実際のモデル利用・電力コスト・運用効率・故障対応がすべてボトルネックになりやすく、そこで“見かけ倒し”になる事例も出ています。

もしよければ、MITが最近発表した「テンソル台数」あるいは「ラック数」「チップ数」「アクセラレータ数」に関する論文・カンファレンス発表を国内外ニュースやarXiv/学会論文から改めて深掘りしてみましょうか。どうされますか?

あなた:

ChatGPT:

興味深い論文があります。Tensor Logic: The Language of AI(arXiv: 2510.12269)です。著者は Pedro Domingos 教授で、AIにおける「論理的推論」と「テンソル代数(多次元配列演算)」を統一しよう、という挑戦的な提案をしています。arXiv+2arXiv+2 以下、数学/理論面と業界的な側面を交えながら、ポイントと雑学を解説します(日本語で)。

✅ 論文の概要と主張

-

論文では「神経ネットワーク(ニューラル)+記号的AI(シンボリック)+統計的モデル」を一つの数理言語(“テンソル論理”)で扱おうとしています。arXiv+1

-

「唯一の構成要素(プログラム構成要素)は“テンソル方程式”である」とされ、論理のルールも、ニューラル演算も、テンソル代数(Einstein summation等)として記述できるという観点が出されています。arXiv+1

-

具体的には、例えば記号推論(例:Datalogのルール) を、テンソルの結合(join)・射影(projection)・要素ごとの非線形性(non‑linearity)として表現できる、という主張があります。arXiv+1

-

また「埋め込み空間(embedding space)での推論(reasoning)を、より信頼性・透明性ある形で行えるようにする」という方向も提示されています。arXiv+1

🔍 純粋数学/テンソル代数的な観点での考察

この論文が面白いのは「論理(命題・関係・推論)をテンソル代数の言葉で再定式化する」という点です。以下、数学的観点からのキーポイントを整理します。

・テンソル代数と論理の関係

-

テンソル(多次元配列)は線形代数・多重線形写像(multilinear map)・テンソル積(tensor product)などとして定義・扱われます。シカゴ大学統計学部+1

-

論理プログラム(例えば Datalog による「親子関係」「祖先関係」のルール」)は、関係(relation)・述語(predicate)・変数・ルールによる結合(join)・射影(projection)などで記述されます。arXiv

-

論文では「この関係・結合・射影と、テンソルの演算(例えば Einstein summation/要素和・積・射影)とは本質的に同じ操作である」という観点を提示しています。例えば、「r(x,y) AND s(y,z) → t(x,z)」のようなルールをテンソル結合+射影+クリップ/非線形変換で書けるという具合です。arXiv+1

・論理をテンソル方程式へ変換する意義

-

分離されていた「学習できる構造(ニューラルネットワーク)」と「明示的に推論できる構造(論理ルール)」を、一様な数学的枠組み(テンソル方程式)に落とし込むことで、両者を混在・連携させやすくする狙いがあります。

-

こうすることで:

-

推論ルールを「テンソル演算として実行でき」かつ「勾配法(gradient‑based learning)で最適化対象にできる」可能性があります。論文では「勾配もテンソル論理プログラムである」との言及があります。arXiv+1

-

埋め込み空間において、論理的な条件・関係をテンソル操作として扱うことで、「なぜそう判断したか」の説明可能性/透明性を高める可能性があります。

-

-

純粋に数学的な面では、これは「関係論理(relational logic)」「データベース結合」「グラフィカルモデル(グラフ/因子モデル)」「ニューラルネットワーク」を、共通のテンソルアルジェブラ(tensor algebra)言語にマップする試みとも言えます。

・留意すべき数学的・理論的ハードル

-

論理推論には「∀(全称)」「∃(存在)」「否定」「再帰」「非単調推論(negation as failure)」「証明の安全性・終了性」など多くの難題があります。論文でも “まだこれら完全には提供されていない” とされています。note(ノート)+1

-

テンソル代数として書けても「正確な証明体系」がその言語内にあるか(soundness, completeness)や、実際に大規模・実用的な推論・学習が可能かはまだ検証フェーズです。

-

また、テンソル計算(特に高次テンソル)やスパーステンソル、メモリ・計算コストの問題、また「論理ルールをテンソル形式にどう落とし込むか」の実践的な設計も挑戦です。

-

つまり「数学的な美しさ・整合性」と「実装・スケーラビリティ」の両立が鍵です。

🧠 業界・研究雑学としての視点

-

この論文がSNS等で「MITが発表した」「AIの歴史を塗り替える」といった形で話題になっているのですが、実際には著者ドミンゴス氏は「ワシントン大学」所属であり、MIT発ではありません。note(ノート)+1 つまり、話題の盛り上がりに対して認識に少しズレがあります。

-

AI分野では「ニューラル(深層学習) vs 記号(論理・知識ベース)」という二つの流派が長年ありました。後者は説明可能性・推論・知識活用に強みがありますが、学習・スケール性には限界があり、前者は膨大なデータからパターンを学べますが「なぜその答えか」が分かりづらい、という点があります。

-

この論文は、まさにその“分断”を数学的に埋めようという方向を示しています。

-

-

実装・産業応用の観点では、もしテンソル論理の考え方が広まれば、「AIモデル構築の言語」「推論ルールと学習モデルの共通基盤」「説明可能なAI(XAI)の構築)」といったところでインパクトになり得ます。

-

ただし、雑誌レビュー・実験実証・産業利用の観点では「まだ初期提案段階」であり、いきなり商用AIがこの言語で組まれるわけではない、というのが冷静な見方です。論文中でも「将来的な言語・実装・ライブラリ・スケーラビリティ」の検討が今後の課題として挙げられています。arXiv+1

🔮 今後のポイント・チェックすべきこと

-

この「テンソル論理(Tensor Logic)」が、どのような実装ライブラリ/言語仕様として出るか(DSL: Domain Specific Language)を確認する。論文ではPython+既存テンソル処理ライブラリと統合できると述べられています。emergentmind.com

-

実際に「論理ルールをどれだけ正確に/大規模にテンソル方程式として動かせるか」「学習できるか(勾配法で最適化できるか)」「透明性・説明性がどう確保されるか」を実験ベンチマークで見る必要があります。

-

他の神経‐記号ハイブリッド(Neuro‑Symbolic AI)研究との比較。たとえば Logic Tensor Networks: Deep Learning and Logical Reasoning from Data and Knowledge(2016)など。arXiv

-

業界実用化の観点では、「テンソル演算のコスト(高次テンソル/スパーステンソル)」「推論速度・メモリ」「分散処理・GPU活用」「どれだけ既存のニューラルモデルと併用できるか」が鍵です。

-

また、「論理的推論=ハルシネーションしないAI」という観点で注目されていますが、実際に“ハルシネーション克服”につながるかは慎重に見るべきです。実装・運用面での検証が未だです。

もしよければ、この論文の 数式構造(テンソル方程式の具体例) を一緒に日本語で追ってみましょうか?また、日本語で理解を助けるスライド/図解も探せます。どうされますか?

0 件のコメント:

コメントを投稿